Présentation du guide

Le monde en ligne joue un rôle de plus en plus prépondérant dans les débats publics et dqns les événements politiques. Parallèlement, la désinformation, les discours de haine et l’extrémisme en ligne ont apparemment saturé le contenu des plateformes de réseaux sociaux, leurs méfaits étant aggravés par des effets de réseau et des systèmes informatiques de plus en plus puissants. Les conséquences négatives pour la société représentent un défi mondial affectant tous les pays et presque tous les domaines du discours public. La désinformation renforce les régimes autoritaires, affaiblit les voix et la participation démocratiques, cible les femmes et les groupes marginalisés, exploite et exacerbe les clivages sociaux et réduit l’opposition au silence. Dans l’ensemble de la sphère publique en réseau 1 la société civile, les gouvernements et le secteur privé sont aux prises avec ces nouvelles menaces en ligne et travaillent, à travers leurs propres réseaux et entre eux, dans le cadre d’un effort de l’ensemble de la société pour améliorer l’intégrité de notre environnement informationnel.

Si la désinformation est depuis longtemps un défi pour la démocratie, l’ère numérique exige un engagement renouvelé et impose une nouvelle urgence afin de faire face à l’ampleur, la rapidité et l’omniprésence des menaces liées à l’information en ligne. Un accès significatif à un environnement informationnel sain fait partie intégrante du fonctionnement de sociétés libres et respectueuses des droits ; en tant que telles, la lutte contre la désinformation et la promotion de l’intégrité de l’information sont des priorités nécessaires pour garantir que la démocratie puisse prospérer dans le monde entier au cours du prochain siècle et au-delà.

COMMENT LE TRAVAIL A ÉTÉ MENÉ

Ce guide est une initiative ambitieuse visant à établir un panorama mondial des mesures de lutte contre la désinformation et de promotion de l’intégrité de l’information – un examen collaboratif de ce qui est fait, de ce qui fonctionne et de qui le fait. Cette ressource a été élaborée par la Fondation internationale pour les systèmes électoraux, l’Institut républicain international et le National Democratic Institute avec le soutien de l’USAID au Consortium pour le renforcement des élections et des processus politiques, et est destinée à servir de guide pour les professionnels, la société civile et les parties prenantes gouvernementales travaillant pour faire progresser l’intégrité de l’information et renforcer la résilience sociétale. La recherche a été menée sur deux ans et dirigée par des experts des trois organisations. L’équipe a mené des recherches dans trois pays et la base de données comprend plus de 275 entrées dans plus de 80 pays de toutes les régions en dehors de l’Antarctique, qui seront mises à jour et étendues au fil du temps. Plus d’une douzaine d’experts externes ont servi de pairs examinateurs et éditeurs. En raison de la COVID-19, certains efforts de recherche ont été réduits. En raison de la portée et de l’ampleur du défi, la recherche est approfondie, mais non exhaustive. Pendant la rédaction, les actions des plateformes de réseaux sociaux, des gouvernements, des acteurs de la société civile et des militants ont continué d’évoluer. En conséquence, nous souhaitons que ce guide soit une plateforme vivante avec des chapitres de fond mis à jour chaque année et que la base de données mondiale soit mise à jour plus régulièrement.

CE QUE CONTIENT LE GUIDE

Points forts

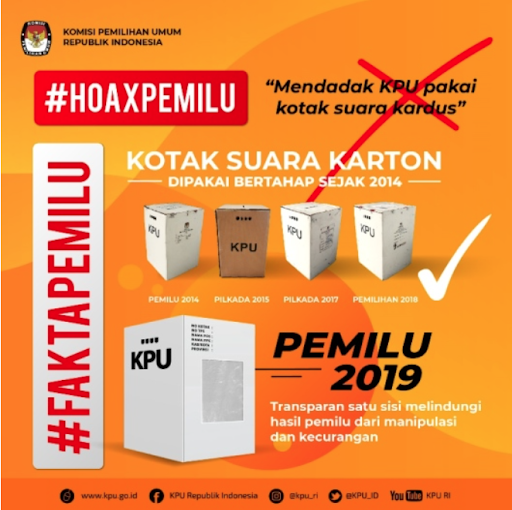

Pendant deux ans, le CEPPS a mené des recherches sur place en Colombie, en Indonésie et en Ukraine. Les acteurs clé ont été interrogés sur leur expérience dans le développement d’interventions, de leur rôle dans le système politique ainsi que sur leur point de vue concernant le paysage de l’information et d’autres questions connexes. Ces pays ont été choisis en fonction des interventions et des programmes pertinents qu’ils ont développés, de leur diversité démographique et géographique, du risque d’intervention étrangère, ainsi que des récentes élections et autres événements politiques critiques. L’Ukraine est en première ligne en termes de problèmes liés à l’espace d’information, car une guerre civile déclenchée par l’invasion russe de la Crimée a créé un espace d’information contesté, souvent influencé par le Kremlin. Démocratie asiatique gigantesque et importante, l’Indonésie a récemment traversé des élections au cours desquelles les réseaux sociaux ont joué un rôle essentiel, suscitant des réponses innovantes, de la part des organes de gestion des élections et de la société civile, pour atténuer les impacts de la désinformation et promouvoir un environnement informationnel sain. La Colombie représente le dernier exemple, un pays avec à la fois des élections récentes et un accord de paix majeur entre le gouvernement et les groupes rebelles mettant fin à une guerre de plusieurs décennies. La négociation du pacte, l’échec d’un référendum et enfin la ratification par le corps législatif se sont succédés au fil des ans et constituent une étude de cas importante sur la manière dont un processus de paix et de réconciliation sont reflétés et négociés en ligne parallèlement aux élections et autres événements politiques.

Des exemples et des citations des trois cas sont intégrés dans le guide pour illustrer les leçons apprises et l’évolution des programmes de lutte contre la désinformation et d’autres interventions. Dans la mesure du possible, des liens vers les entrées de la base de données mondiale des interventions informationnelles sont fournis. La base de données est l’initiative la plus importante au sein de la communauté démocratique dont le but est de cataloguer les bailleurs de fonds, les différents types de programmes, les organisations et les descriptions du projet. En outre, les sujets tratiés comprennent des citations d’entretiens avec des parties prenantes, des examens et des analyses de programmes, ainsi que des rapports sur la surveillance et l’évaluation. Des rapports des médias et de la littérature universitaire axés sur l’impact et l’efficacité ont également été inclus. Enfin, ce guide se veut un document vivant, et la base de données et les sujets seront périodiquement révisés et améliorés pour refléter l’évolution continue de l’environnement en ligne et du monde réel.

Les sujets sont divisés en trois grandes catégories, examinant les rôles de groupes de parties prenantes spécifiques, les réponses juridiques, normatives et de recherche, ainsi que des questions transversales pour lutter contre la désinformation ciblant les femmes et les groupes marginalisés, et les élections. Les sujets comprennent :

Les sujets comprennent :

RÔLES

- La sectionRenforcement des capacités de la société civile pour atténuer et contrer la désinformation examine divers efforts déployés par les organisations de la société civile pour lutter contre la désinformation et promouvoir l’intégrité de l’information par le biais de programmes et d’autres initiatives, notamment la vérification des faits, l’éducation aux médias, la recherche en ligne et parmi d’autres méthodes.

- La sectionAider les partis politiques à protéger l’intégrité des informations politiques explore l’impact des campagnes de désinformation et des discours de haine sur les partis politiques dans les pays en développement, et fournit des recommandations politiques aux partis pour lutter contre les formes de contenu préjudiciables et promouvoir les formes positives.

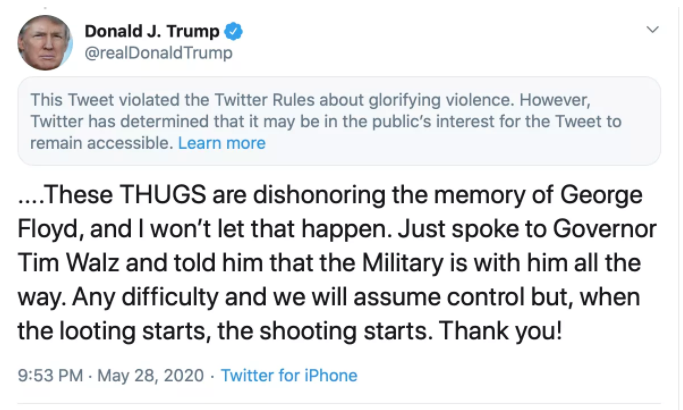

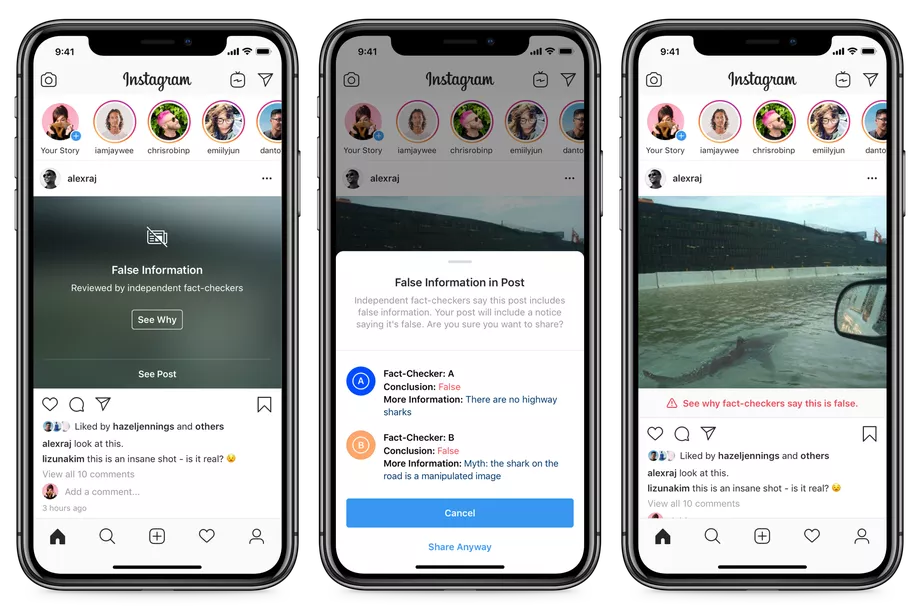

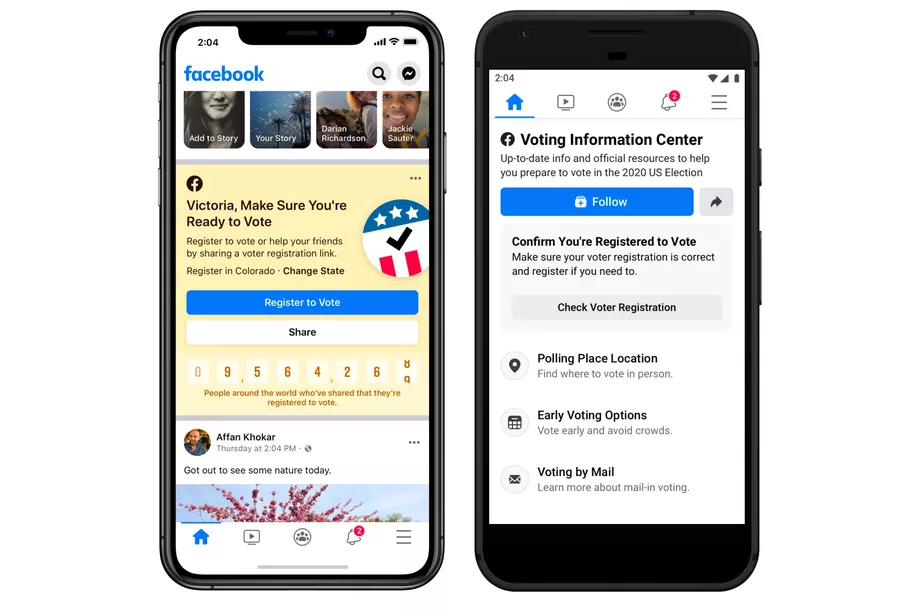

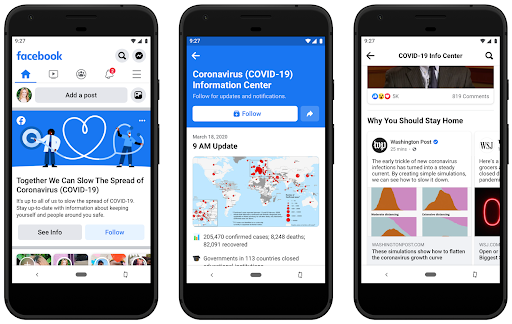

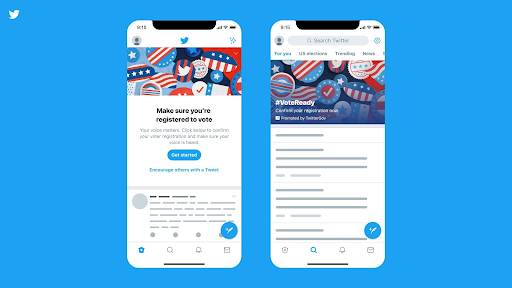

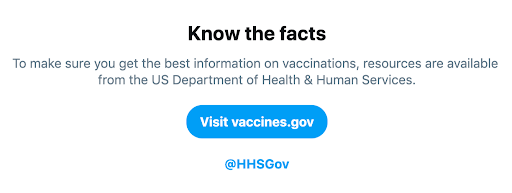

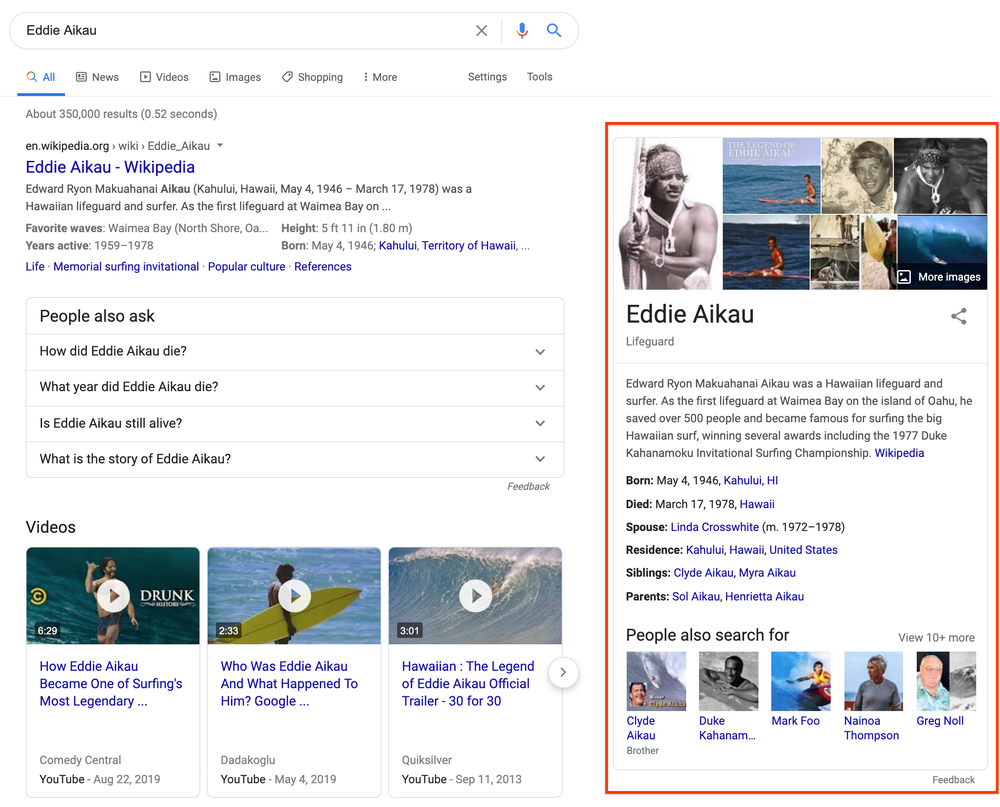

- La sectionEngagement spécifique des plateformes pour l’intégrité de l’information explore les différentes réponses politiques, d’application et de partenariat avec les plateformes de réseaux sociaux (grandes et petites) pour relever les défis posés par la désinformation.

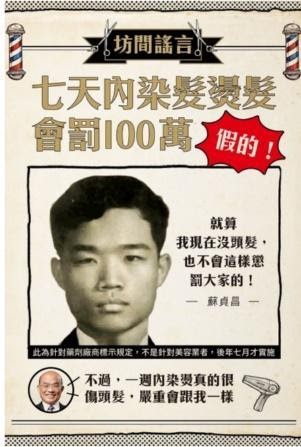

- Les approches des organismes de gestion des élections (OGE) pour lutter contre la désinformation explorent les différents rôles que jouent les OGE dans la lutte contre la désinformation et proposent des stratégies proactives, réactives et collaboratives que les autorités électorales peuvent envisager.

- La section Exposer la désinformation par la surveillance des élections examine le travail et les méthodes de surveillance internationale et nationale de l’espace d’information en tant que composante de l’observation des élections.

RÉPONSES

- La section Élaborer des normes et des standards sur la désinformation et les problèmes d’intégrité de l’information donne un aperçu des normes et standards mondiaux qui ont été élaborés pour contrer la désinformation dans le respect des droits humains.

- La section Lois, règlements et mécanismes d’application explore les façons dont les cadres juridiques nationaux régissant les élections abordent les réseaux sociaux et fournissent une ressource aux législateurs et aux bailleurs de fonds internationaux qui envisagent de modifier leurs propres cadres électoraux.

- La section Outils de recherche et d’évaluation pour contrer la désinformation explore une variété d’outils de recherche que les professionnels utilisent pour comprendre les acteurs de la menace, les cibles, l’écosystème de l’information et l’impact des programmes.

DIMENSIONS TRANSVERSALES

- La section Comprendre les dimensions de genre de la désinformation explore comment les campagnes de désinformation, les fausses informations virale et les discours de haine ciblent et affectent particulièrement les femmes et les personnes ayant des orientations sexuelles et des identités de genre diverses en exploitant et en manipulant leur identité propre. En conséquence, cette section et tous les autres sujets comprennent des considérations à propos du genre et des groupes marginalisés en ce qui concerne l’élaboration de programmes et d’autres interventions.

La base de données des interventions informationnelles fournit un ensemble complet d’interventions que les professionnels, les donateurs et les analystes peuvent utiliser à l’échelle mondiale pour comprendre et lutter contre la désinformation.

9 choses importantes à retenir

En effectuant cette analyse et en examinant ces aspects critiques des problèmes, l’équipe de recherche a identifié des points clés à retenir afin d’orienter les efforts de lutte contre la désinformation à l’avenir.

COMPRENDRE LA DÉSINFORMATION

Des travaux importants ont été réalisés ces dernières années pour comprendre et diagnostiquer conceptuellement les désordres de l’information. Pour fonder conceptuellement notre analyse, ce guide fonde ses définitions et sa compréhension des problèmes ainsi que des solutions principalement sur les travaux de Data & Society, de First Draft et du Computational Propaganda Project de l’Oxford Internet Institute. Ces trois ressources fondamentales sont respectées dans l’ensemble de la communauté d’analyse de la désinformation, en raison notamment de la manière dont leurs cadres conceptuels se prêtent à une adaptation pour une application pratique.

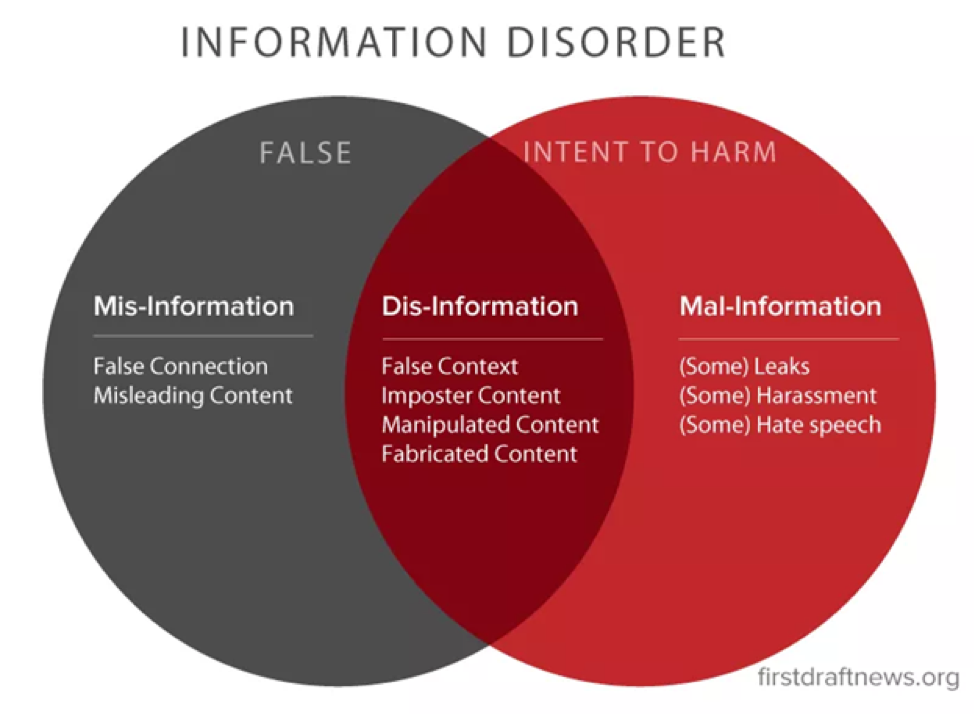

Information Disorder de First Draft fournit des définitions claires du désordre de l’information, des implications pour la démocratie, du rôle de la télévision, des implications pour les médias locaux, du microciblage, de l’amplification informatique, des bulles de filtres et des chambres d’écho, et de la baisse de confiance envers les médias et les institutions publiques. Le cadre décrit également comment la fausse information (informations transmises sans intention de tromper), la désinformation (informations incorrectes transmises intentionnellement) et l’information malveillante (informations vraies rendues publiques dans l’intention de nuire) contribuent toutes au désordre, qui peut également être compris comme contribuant à la corruption de l’intégrité de l’information dans les systèmes et les discours politiques.

De Wardle Claire et Hossein Derakhshan. « Information Disorder: Toward an Interdisciplinary Framework for Research and Policymaking » (Trouble de l’information : vers un cadre interdisciplinaire pour la recherche et l’élaboration de politiques). Conseil de l’Europe, 31 octobre 2017. https://shorensteincenter.org/information-disorder-framework-for-research-and-policymaking/.

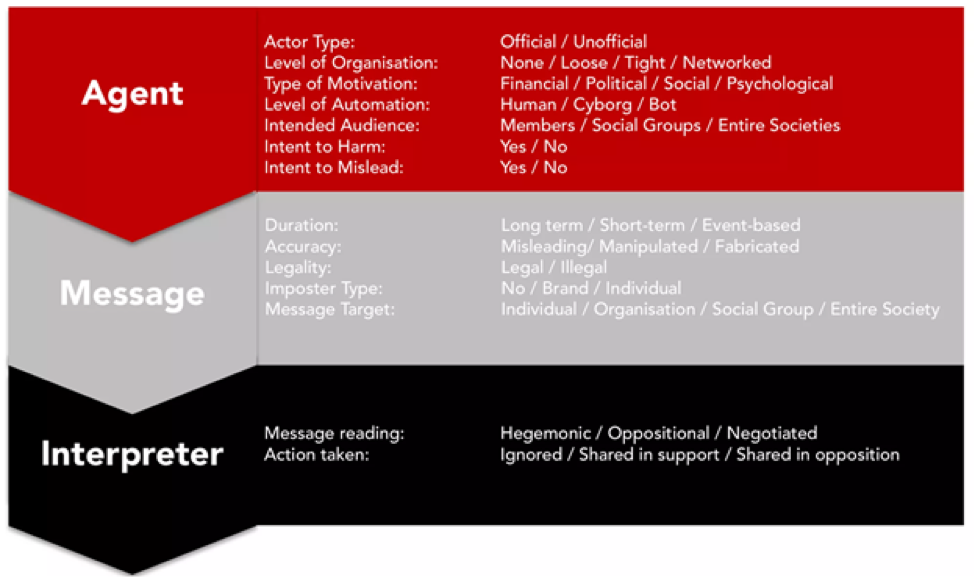

Le cadre du désordre de l’information se concentre également sur les éléments de l’écosystème de l’information, y compris l’agent d’information (ou producteur), le message et l’interprète. Les messages passent par plusieurs phases, à savoir la création, la production et la distribution. Ces aspects nous permettent d’interpréter différents types d’initiatives, qu’elles portent sur un élément de ces trois composantes, plusieurs voir tous. Les cadres juridiques et réglementaires et les normes et standards peuvent cibler tous ces aspects, et différents acteurs tels que les plateformes, les organisations de la société civile et les gouvernements peuvent concevoir des réponses qui les abordent de différentes manières. Par exemple, les initiatives d’éducation aux médias ciblent les interprètes, tandis que la modération du contenu se concentre sur les messages et les agents.

De Wardle Claire et Hossein Derakhshan. « Information Disorder: Toward an Interdisciplinary Framework for Research and Policymaking » (Trouble de l’information : vers un cadre interdisciplinaire pour la recherche et l’élaboration de politiques). Conseil de l’Europe, 31 octobre 2017. https://shorensteincenter.org/information-disorder-framework-for-research-and-policymaking/.

L’Oxford Internet Institute (OII) a élaboré le terme « propagande informatique » et définit cette pratique comme « l’assemblage de plateformes de réseaux sociaux, d’agents autonomes et de mégadonnées chargés de manipuler l’opinion publique ».2 Ce cadre nous permet d’élargir notre compréhension des menaces dans l’espace en ligne au-delà de la désinformation, sous la forme d’autres types de manipulation en ligne, qu’ils soient automatisés ou non. Cela aide également à envisager le problème comme appelant un ensemble de réponses techniques, sociologiques et politiques. Pour aider à comprendre la viralité de la désinformation, les travaux de l’OII montrent comment les études sur les communications, le comportement et la psychologie, ainsi que l’informatique, les données et les sciences de l’information, ont toutes un rôle à jouer.

« Oxygen of Amplification » de Data & Society montre comment les médias traditionnels jouent un rôle dans l’amplification des faux récits et comment ils peuvent être manipulés pour promouvoir les fausses informations et la désinformation de différentes manières. Un autre groupe de recherche qui rassemble divers aspects de l’analyse des médias et des données ainsi que de la recherche en sciences sociales aide également à définir les termes et les normes. Notre glossaire s’appuie sur le rapport de Data & Society sur le Lexicon of Lies 3, ainsi que sur le Essential Glossary de First Draft, tiré de son étude intitulée « Information Disorder », ainsi que sur d’autres sources cultivées via notre base de données mondiale d’approches et d’autres documents, notamment les conseils de l’USAID4 et d’autres organisations, dont le CEPPS. Des concepts du domaine des techniques, des médiats et de la communication sont inclus dans les sections et ces termes clé aident à décrire le problème sous différents angles.

Notes de bas de page

1 Benkler, Yochai. The Wealth of Networks: How Social Production Transforms Markets and Freedom (La richesse des réseaux : comment la production sociale transforme les marchés et la liberté). Yale University Press, 2006.

2 Howard, PN, et Sam Woolley. « Political Communication, Computational Propaganda, and Autonomous Agents » (Communication politique, propagande informatique et agents autonomes). Édité par Samuel Woolley et Philip N. Howard. International Journal of Communication 10, no Numéro spécial (2016) : 20.

3 Jack, Caroline. « Lexicon of Lies: Terms for Problematic Information » (Lexique des mensonges : termes pour les informations problématiques). Data & Society, 9 août 2017. https://datasociety.net/output/lexicon-of-lies/.

4 Disinformation Primer, Center for Excellence on Democracy, Human Rights and Governance, USAID, février 2021.

L’INEC du Nigeria déploie un

L’INEC du Nigeria déploie un

la reçoit les plaintes de désinformation pendant la période électorale de

la reçoit les plaintes de désinformation pendant la période électorale de  7.1 Travailler pour aider les OGE à améliorer la diffusion d’informations crédibles

7.1 Travailler pour aider les OGE à améliorer la diffusion d’informations crédibles

Les campagnes sur les réseaux numériques et sociaux augmentent les possibilités de masquer l’origine des contenus en agissant par l’intermédiaire de tiers. Les mesures qui cherchent à apporter de la transparence dans ces flux financiers devront considérer non seulement qui est le payeur et le bénéficiaire, mais aussi qui est l’entité payée - la plateforme de réseaux sociaux elle-même ? Des influenceurs qui exploitent des pages ou des flux sur leurs plateformes respectives et qui peuvent être payés pour promouvoir du contenu politique ? Les employés du secteur public, qui font campagne via les réseaux sociaux au travail ? Des sociétés de relations publiques ou des entités de création de contenu (telles que des fermes de contenu ou des fermes de trolls) qui produisent et diffusent du contenu au nom d’une entité politique ?

Les campagnes sur les réseaux numériques et sociaux augmentent les possibilités de masquer l’origine des contenus en agissant par l’intermédiaire de tiers. Les mesures qui cherchent à apporter de la transparence dans ces flux financiers devront considérer non seulement qui est le payeur et le bénéficiaire, mais aussi qui est l’entité payée - la plateforme de réseaux sociaux elle-même ? Des influenceurs qui exploitent des pages ou des flux sur leurs plateformes respectives et qui peuvent être payés pour promouvoir du contenu politique ? Les employés du secteur public, qui font campagne via les réseaux sociaux au travail ? Des sociétés de relations publiques ou des entités de création de contenu (telles que des fermes de contenu ou des fermes de trolls) qui produisent et diffusent du contenu au nom d’une entité politique ?